近几年来,深度学习的研究和应用的热潮持续高涨,各种开源深度学习框架层出不穷,包括 TensorFlow,Keras,MXNet,PyTorch,CNTK,Theano,Caffe,DeepLearning4,Lasagne,Neon,等等。Google,Microsoft 等商业巨头都加入了这场深度学习框架大战,当下最主流的框架当属 TensorFlow,Keras,MXNet,PyTorch,接下来我对这四种主流的深度学习框架从几个不同的方面进行简单的对比。

TensorFlow:

TensorFlow 是 Google Brain 基于 DistBelief 进行研发的第二代人工智能学习系统,其命名来源于本身的运行原理,于 2015 年 11 月 9 日在 Apache 2.0 开源许可证下发布,并于 2017 年 12 月份预发布动态图机制 Eager Execution。

Keras:

Keras 是一个用 Python 编写的开源神经网络库,它能够在 TensorFlow,CNTK,Theano 或 MXNet 上运行。旨在实现深度神经网络的快速实验,它专注于用户友好,模块化和可扩展性。其主要作者和维护者是 Google 工程师 FrançoisChollet。

MXNet:

MXNet 是 DMLC(Distributed Machine Learning Community)开发的一款开源的、轻量级、可移植的、灵活的深度学习库,它让用户可以混合使用符号编程模式和指令式编程模式来最大化效率和灵活性,目前已经是 AWS 官方推荐的深度学习框架。MXNet 的很多作者都是中国人,其最大的贡献组织为百度。

PyTorch:

PyTorch 是 Facebook 于 2017 年 1 月 18 日发布的 python 端的开源的深度学习库,基于 Torch。支持动态计算图,提供很好的灵活性。在今年(2018 年)五月份的开发者大会上,Facebook 宣布实现 PyTorch 与 Caffe2 无缝结合的 PyTorch1.0 版本将马上到来。

有关四个框架的一些基本属性的比较如表 1-1 所示:

表 1-1 各个框架的相关属性

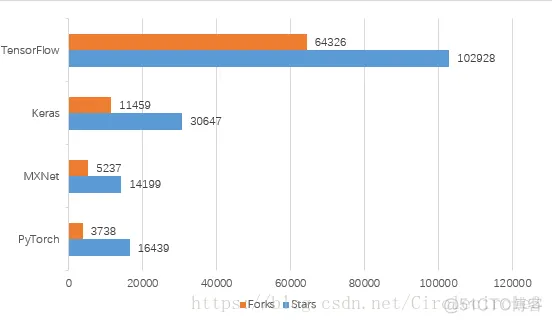

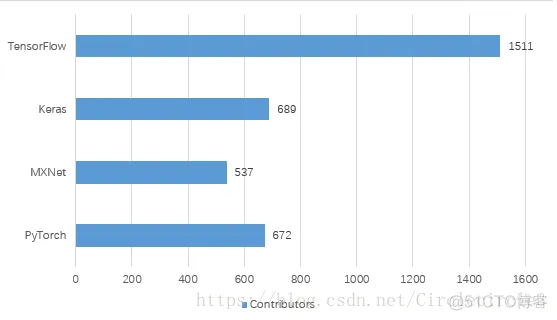

四个深度学习库均为开源,我们可以通过其在 Github 上的数据看出他们在行业中的流行程度,截止到 2018 年 6 月 17 日 Github 上数据如表 2-1、表 2-2 所示。

表 2-1

表 2-2

TensorFlow 主要支持静态计算图的形式,计算图的结构比较直观,但是在调试过程中十分复杂与麻烦,一些错误更加难以发。但是 2017 年底发布了动态图机制 Eager Execution,加入对于动态计算图的支持,但是目前依旧采用原有的静态计算图形式为主。TensorFlow 拥有 TensorBoard 应用,可以监控运行过程,可视化计算图。

Keras 是基于多个不同框架的高级 API,可以快速的进行模型的设计和建立,同时支持序贯和函数式两种设计模型方式,可以快速的将想法变为结果,但是由于高度封装的原因,对于已有模型的修改可能不是那么灵活。

MXNet 同时支持命令式和声明式两种编程方式,即同时支持静态计算图和动态计算图,并且具有封装好的训练函数,集灵活与效率于一体,同时已经推出了类似 Keras 的以 MXNet 为后端的高级接口 Gluon。

PyTorch 为动态计算图的典型代表,便于调试,并且高度模块化,搭建模型十分方便,同时具备及其优秀的 GPU 支持,数据参数在 CPU 与 GPU 之间迁移十分灵活

对于深度学习框架的学习难易程度以及使用的简易度还是比较重要的,我认为应该主要基于框架本身的语言设计、文档的详细程度以及科技社区的规模考虑。对于框架本身的语言设计来讲,TensorFlow 是比较不友好的,与 Python 等语言差距很大,有点像基于一种语言重新定义了一种编程语言,并且在调试的时候比较复杂。每次版本的更新,TensorFlow 的各种接口经常会有很大幅度的改变,这也大大增加了对其的学习时间;

Keras 是一种高级 API,基于多种深度学习框架,追求简洁,快速搭建模型,具有完美的训练预测模块,简单上手,并能快速地将所想变现,十分适合入门或者快速实现。但是学习会很快遇到瓶颈,过度的封装导致对于深度学习知识的学习不足以及对于已有神经网络层的改写十分复杂;

MXNet 同时支持命令式编程和声明式编程,进行了无缝结合,十分灵活,具备完整的训练模块,简单便捷,同时支持多种语言,可以减去学习一门新主语言的时间。上层接口 Gluon 也极其容易上手;PyTorch 支持动态计算图,追求尽量少的封装,代码简洁易读,应用十分灵活,接口沿用 Torch,具有很强的易用性,同时可以很好的利用主语言 Python 的各种优势。

对于文档的详细程度,TensorFlow 具备十分详尽的官方文档,查找起来十分方便,同时保持很快的更新速度,但是条理不是很清晰,教程众多;Keras 由于是对于不同框架的高度封装,官方文档十分详尽,通俗易懂;MXNet 发行以来,高速发展,官方文档较为简单,不是十分详细,存在让人十分迷惑的部分,框架也存在一定的不稳定性;

PyTorch 基于 Torch 并由 Facebook 强力支持,具备十分详细条理清晰的官方文档和官方教程。对于社区,庞大的社区可以推动技术的发展并且便利问题的解决,由 Google 开发并维护的 TensorFlow 具有最大社区,应用人员团体庞大;

Keras 由于将问题实现起来简单,吸引了大量研究人员的使用,具有很大的用户社区;MXNet 由 Amazon,Baidu 等巨头支持,以其完美的内存、显存优化吸引了大批用户,DMLC 继续进行开发和维护;PyTorch 由 Facebook 支持,并且即将与 Caffe2 无缝连接,以其灵活、简洁、易用的特点在发布紧一年多的时间内吸引了大量开发者和研究人员,火爆程度依旧在不断攀升,社区也在不断壮大。

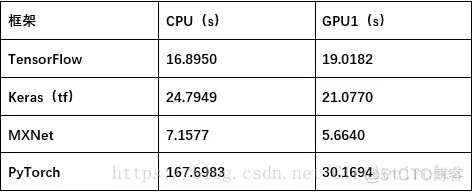

为了比较四个框架的性能(主要是运行速度),我进行了三个不同的实验,对于不同的神经网络以及不同类型的数据集在分别在 CPU、GPU 环境下进行了测试。

CPU 环境:Ubuntu14.04 内存 32GB AMD Opteron(tm) Processor 4284

GPU 环境 1:Ubuntu16.04 内存 32GB Quadro P2000(5GB 显存)

Intel(R) Xeon(R) CPU E5-2637 v4 @ 3.50GHz

GPU 环境 2:Ubuntu16.04 内存 16GB Tesla K40(12GB 显存)

Intel(R) Xeon(R) CPU E5-2650 v3 @ 2.30GHz

代码地址: https://github.com/CircleXing001/DL-tools

以下实验时间均为总训练时间,GPU 环境下包括数据由内存复制到 GPU 的时间,不包括数据读入内存所需的时间。

实验一:基于北京 pm2.5 数据集的多变量时序数据预测问题

数据集: https://archive.ics.uci.edu/ml/datasets/Beijing+PM2.5+Data

模型:简单的单层 LSTM + 全连接层,如下图所示:

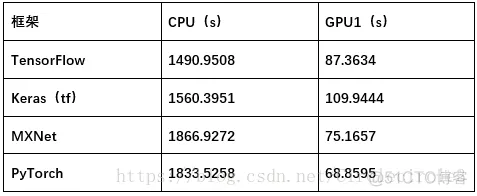

进行训练 50epoches,实验结果如表 5-1 所示:

表 5-1

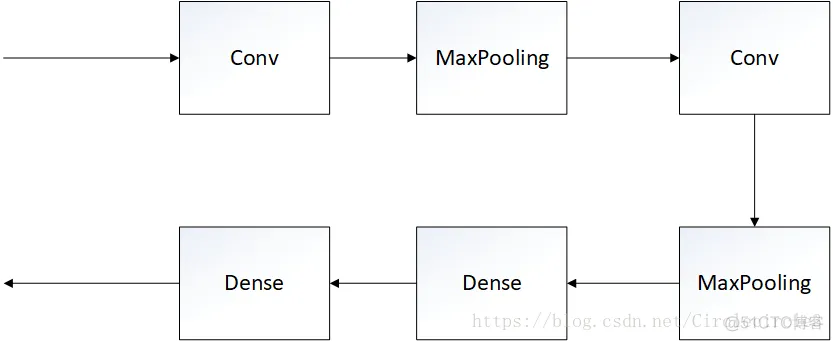

实验二:基于 Mnist 数据集的分类问题

模型:两层卷积神经网络 + 全连接层,如下图所示:

进行训练 10epoches,实验结果如表 5-2 所示:

表 5-2

实验三:基于 DAQUAR 数据集的视觉问答问题

数据集: https://www.mpi-inf.mpg.de/departments/computer-vision-and-multimodal-computing/research/vision-and-language/visual-turing-challenge/

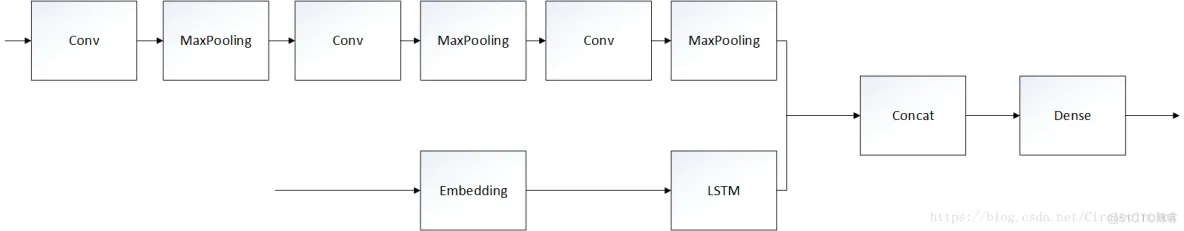

模型:卷积神经网络 + LSTM,具体如下图所示:

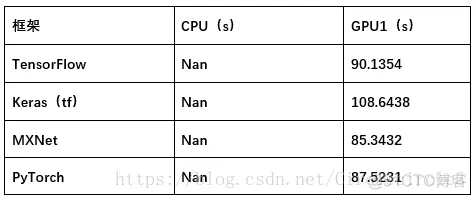

将数据缩放至 50*50,进行训练 5epoches,实验结果如表 5-3 所示:

表 5-3

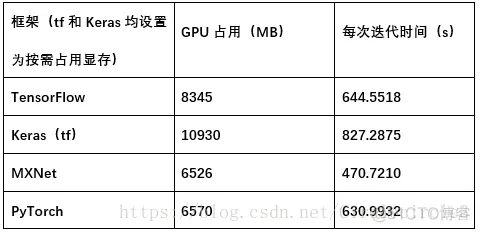

在 GPU 环境 2(Ubuntu16.04 + 内存 16GB +Tesla K40(12GB 显存)+Intel(R) Xeon(R) CPU E5-2650 v3 @ 2.30GHz)

对上述实验三中 224*224 数据进行实验,对比四种框架对于硬件(GPU)的利用率,结果见表 5-4。

表 5-4

通过上述实验我们可以发现,不同的深度学习框架对于计算速度和资源利用率的优化存在一定的差异:Keras 为基于其他深度学习框架的高级 API,进行高度封装,计算速度最慢且对于资源的利用率最差;在模型复杂,数据集大,参数数量大的情况下,MXNet 和 PyTorch 对于 GPU 上的计算速度和资源利用的优化十分出色,并且在速度方面 MXNet 优化处理更加优秀;相比之下,TensorFlow 略有逊色,但是对于 CPU 上的计算加速,TensorFlow 表现更加良好。

免责声明:本文系网络转载或改编,未找到原创作者,版权归原作者所有。如涉及版权,请联系删