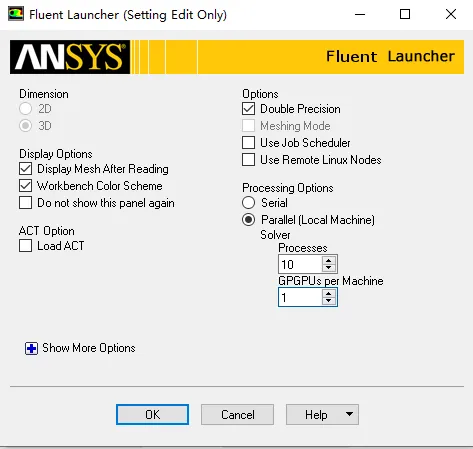

用Fluent开启GPU进行计算,过程其实很简单,不过现在只找到采用N卡进行计算的方法。首先在开始界面需要设置并行计算的核数与你要用来计算的GPU数量,一般电脑都只有一块显卡,所以设置为1就可以了。

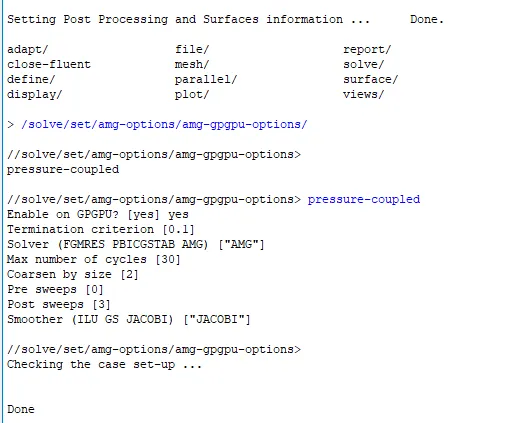

打开之后就需要用命令行去打打开显卡计算并进行设置,命令行/solve/set/amg-options/amg-gpgpu-options/,后面还需要跟上你想并行计算的模型比如我这里的压力耦合计算,后面是一些精度和求解方法的设置,其中精度和迭代次数比较重要,搞得不好反倒会发散,比如这里设置为0.1,如果过大那时间就会比较长。

设置好了之后运行就可以了,也没什么需要注意的,但是有的模型本身就有限制用不了并行加速方法,具体的可以参考这里的内容https://www.nvidia.cn/data-center/gpu-accelerated-applications/ansys-fluent/

我这里模型比较小,计算时间就2分钟效果提升不明显,大的模型会明显一些,但显卡确实用起来了。

如果是自己编写的程序想并行求解的会麻烦很多,但也不是没有办法。

后续更新如何用代码主要是基于matlab进行三维模型计算,包括读取网格(基于Openfoam格式的网格),处理拓扑,离散求解一系列流程。

免责声明:本文系网络转载或改编,未找到原创作者,版权归原作者所有。如涉及版权,请联系删

武汉格发信息技术有限公司,格发许可优化管理系统可以帮你评估贵公司软件许可的真实需求,再低成本合规性管理软件许可,帮助贵司提高软件投资回报率,为软件采购、使用提供科学决策依据。支持的软件有: CAD,CAE,PDM,PLM,Catia,Ugnx, AutoCAD, Pro/E, Solidworks ,Hyperworks, Protel,CAXA,OpenWorks LandMark,MATLAB,Enovia,Winchill,TeamCenter,MathCAD,Ansys, Abaqus,ls-dyna, Fluent, MSC,Bentley,License,UG,ug,catia,Dassault Systèmes,AutoDesk,Altair,autocad,PTC,SolidWorks,Ansys,Siemens PLM Software,Paradigm,Mathworks,Borland,AVEVA,ESRI,hP,Solibri,Progman,Leica,Cadence,IBM,SIMULIA,Citrix,Sybase,Schlumberger,MSC Products...