前段时间,浪潮与百度联合发布了面向智慧计算的创新产品--SR-AI整机柜服务器。这款产品符合最新的天蝎2.5标准,是全球首个采用PCIe Fabric互联架构设计的AI方案,为更大规模数据集和深层神经网络领域,提供更强性能的AI计算平台。

浪潮百度联合发布SR-AI整机柜服务器

单节点16卡、单物理集群64卡的超高密扩展能力,512TFlops的性能,ns级的延迟等性能参数都让人眼前一亮。但是或许你还有些疑问,为什么要设计如此强大的AI计算设备?能够给我带来什么样的价值?这么大的功率密度下能保证稳定性么?本文就尝试解答你的这些疑惑。

从人工智能的兴衰看计算力的重要性

1950 年,著名的图灵测试诞生,按照艾伦·图灵的定义:如果一台机器能够与人类展开对话而不能被辨别出其机器身份,那么称这台机器具有智能。图灵还预言了创造出具有真正智能的机器的可能性。紧接着西洋跳棋程序和国际象棋程序相继诞生,人工智能游戏也被当着衡量人工智能进展的标准之一。

但是随着更多人工智能相关的投入,人们发现AI却没有按照预想的结果发展,由于计算机性能的瓶颈、计算复杂性的指数级增长、数据量缺失等问题,一些难题看上去好像完全找不到答案。人工智能也因此进入了低潮。

而这些问题进入21世纪才开始被逐步解决。2012年,吴恩达和Jeff Dean带领的Google Brain研究小组用1000台服务器(包含2000颗CPU、16000多个处理核心),建造了一个由10亿多个连接点构成的神经网络,从1000万张YouTube截图对这个神经网络进行训练,经由了10天时间的运转,让它认出了猫。

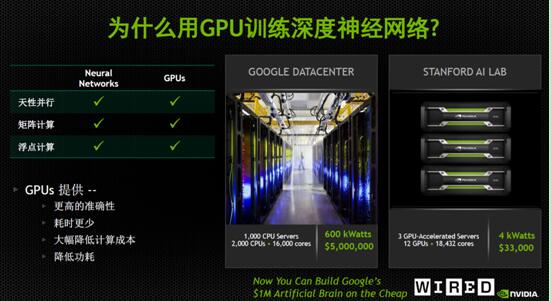

由此可见,随着互联网数据中心的计算集群和计算能力大增,越来越多的AI应用得以实现。但其中还可以看到另外一个问题,训练一个模型使用了1000台服务器的集群,因此这是互联网巨头才能玩得起的"土豪游戏"。

谷歌和斯坦福AI实验室识别猫所需要的性能对比

谷歌和斯坦福AI实验室识别猫所需要的性能对比

然而,在谷歌实验的第二年(2013年)斯坦福大学AI实验室用3台GPU服务器,12颗GPU就达到了同样的性能。GPU服务器所具备的超强并行计算能力开始被人工智能公司所重视,并由此开启了AI的大爆发。后面发生的事,大家就很熟悉了,AlphaGo战胜李世石、百度无人车路测成功···

在这些AI应用的背后是不断发展的计算平台,从单机单卡、到单机多卡、到多机多卡集群,计算密度也从2卡、4卡提升到更高的8卡。但人工智能应用对计算力的需求似乎永无止境,单机8卡的GPU服务器也不能满足单一超大规模模型的训练,而多服务器集群也因为跨节点通信的延迟导致效率损耗严重。

因此,更高的单机点计算密度,更大规模、更低延迟的计算集群,成为人工智能应用的一致诉求。近日,浪潮发布的单节点16卡、单物理集群64卡的SR-AI整机柜就成了备受期待的AI计算利器。

64块GPU卡的物理计算集群是如何炼成的

传统的GPU服务器通常为2卡、4卡最多8卡,每个节点空间和PCI-E资源有限,所能挂在的GPU设备的数量也较少。因此在训练复杂模型时,需要通过网络和相关控制软件组成一个GPU计算集群。但不同节点所挂载的GPU卡间通信,是需要走外部的网络,这样会有很高的延迟。

反观浪潮SR-AI整机柜服务器,这是全球首个采用PCIe Fabric互联架构设计的产品。采用了完全颠覆式的架构,GPU和CPU物理解耦,使二者可灵活扩展。SR-AI整机柜中的GPU Box中仅包含16块GPU卡以及相关的主板,通过线缆的连接到PCIe Switch中,再经由Switch连接到前端的计算节点,由此组成一套完整的GPU计算系统。而PCIe Switch可以挂接4个GPU Box,也就是说单个GPU计算系统可以最大可扩展64块GPU,计算能力飙升至512TFlops以上。

更重要的是,这套系统中的64块GPU卡间的通信全部通过PCIE协议,不需要PCIE到TCP/IP协议的转化,因此延迟将会大大降低。下面就来看看浪潮SR-AI整机柜到底能够降低多少延迟。

延迟可降低50%以上,达到ns级

在传统的GPU集群中,GPU Server1如果要与Server2通信,数据首先会经过一次PCI-E线路的(0.5us延迟)才能到达Server1 的CPU,然后经过一次QPI到达IB交换机,然后经过IB网络(1us延迟)到达Server2的CPU,在经历以此QPI延迟才能到达PCI-E线路,最后还需要经历一次PCIE(0.5us延迟),才能最终到达Server2的GPU卡中。这样,跨节点GPU交互在进行通信时至少经过5次路径/协议转换,至少2us的延迟。

相比于传统GPU扩展方式,SR-AI整机柜所实现的协处理资源池化的架构,能够实现GPU之间仅依赖PCI-E进行通信,延迟可降低50%以上。并且借助GPUDirect技术,使GPU与GPU实现直接的数据交互,而不再需要经由CPU的跳转,大幅降低跨节点GPU间的通信延迟,最终使GPU计算集群的延迟下降到ns级。

超高功率密度下,如何保证系统散热?

相比CPU,GPU的TDP(Thermal Design Power,散热设计功耗)要高出很多。比如22核心的Intel至强E5-2699V4处理器TDP只有145W,而单块Nvidia P100 GPU卡的TDP则是250W。那么SR-AI整机柜服务器在单节点内部署16块GPU卡,功耗就达到了4800W。如何保证良好的散热,让GPU Box保持在适宜的温度内是维持计算系统稳定的关键。

多次精密仿真实现优异散热性能

在4U高度内给16颗大功率GPU散热,就必须在节点内实现冷热风道的隔离(因为任何被GPU加热后的风流不能再给其他GPU进行散热),这样才能够降低风扇负载,保证的稳定性。为此浪潮采用散热仿真软件Flotherm进行了大量的评估和验证,最终确定采用阶梯双风道方案(前8颗,后8颗,竖着摆放),内部通过精细的挡风板、风道设计,使风扇气流能够对每块GPU卡进行充分散热。

另外在风扇的调控上,SR-AI整机柜采用最新的PID数字风扇调控方式,该方式采用模糊控制设计思路,目标是控制发热器件时刻工作在某一较高温度,而不刻意去要求风扇具体转速,这样在系统压力不大时,风扇可以处于较低的转速,能够实现节能。作为较大型的复杂系统,SR-AI整机柜存在控制信号延迟、链路较长等问题,故而在实际操作过程中确实经过了大量设定参数的修改与修订(修改主要指实现软件的控制方式修改,修订指PID变量的不同数值的调整),整个过程贯穿了项目设计始终,最终使单节点16块GPU卡的超高密度计算集群的能够保证高负载下也能常年运行的完美状态。

目前,浪潮是业界拥有单节点2/4/8/16卡等最丰富GPU服务器阵列的厂商,在软件方面,浪潮将高效深度学习框架Caffe-MPI开源,与众多开发者共同优化,为深度学习的用户提供了更便捷、更高效的应用手段。2016年浪潮在国内人工智能计算领域的市场份额超过60%,为百度、阿里巴巴、腾讯、奇虎、科大讯飞、Face++等国内知名AI相关企业提供计算力支撑。

免责声明:本文系网络转载或改编,未找到原创作者,版权归原作者所有。如涉及版权,请联系删