上期文章我们分享了NLP 自然语言处理的基础知识,本期我们分享几个比较流行的中文分词库,且这些中文分词库绝大部分是Java程序编写的,在linux系统上很容易使用,但是在windows环境下,如何使用python来使用这些分词库??

HanLP

HanLP 是由一系列模型与算法组成的 Java 工具包,目标是普及自然语言处理在生产环境中的应用。HanLP 具备功能完善、性能高效、架构清晰、语料时新、可自定义的特点。在提供丰富功能的同时,HanLP 内部模块坚持低耦合、模型坚持惰性加载、服务坚持静态提供、词典坚持明文发布,使用非常方便,同时自带一些语料处理工具,帮助用户训练自己的语料。

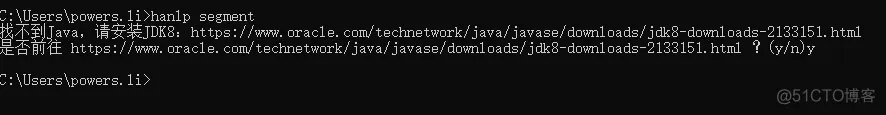

当然python 环境下,hanlp名称为pyhanlp,Python下安装直接在cmd命令框中输入pip install pyhanlp 即可,软件会自动安装所依赖的其他库,安装完成后,在cmd命令框中输入hanlp segment ,使用命令hanlp segment进入交互分词模式,输入一个句子并回车,HanLP会输出分词结果,前提是你的电脑开发环境已经安装好。

此时,软件会先下载hanlp所需要的语言模型,大概1.2G,由于服务器都是国内的,所以下载速度会很快

模型下载

模型下载完成后,hanlp会检测电脑系统上面是否有Java环境,毕竟HanLP 是由一系列模型与算法组成的 Java 工具包

Java环境下载

若没有安装Java,按照软件提示的网站下载安装自己系统的版本即可。

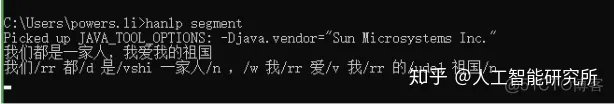

若一切没有问题,便可以输入一段话,进行分词操作

中文分词

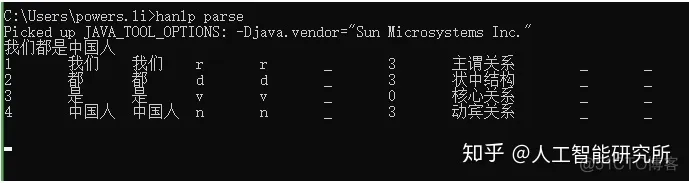

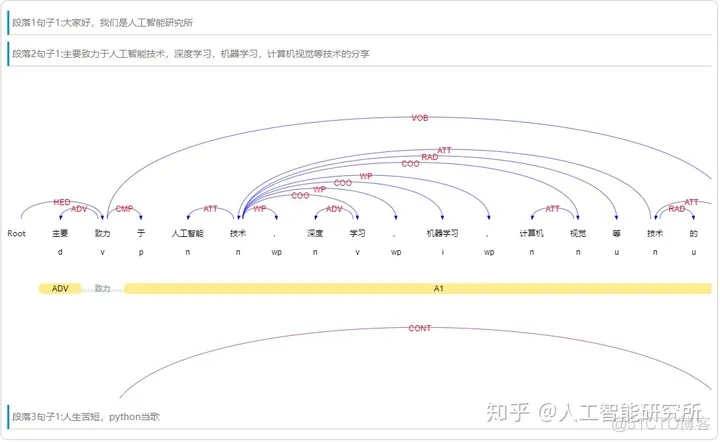

依存句法分析,命令为hanlp parse,同样支持交互模式和重定向,在cmd命令框中输入指令,并输入一段话

中文分词

pyhanlp的python使用方法

安装pyhanlp后,以上我们可以使用在cmd命令框中输入指令进行操作,当然我们同样也可以使用python 编程进行操作

分词使用

依存分析使用

pyhanlp可视化

pyhanlp提供了一个很好的可视化界面,可以直接在官网上进行可视化操作,当然在本地,只要一句命令就能启动一个web服务

浏览器输入http://localhost:8765就能看到可视化界面,能看到分词结果和依存关系的结果,是不是很直观。这个网页上还有安装说明、源码链接、文档链接、常见的问题,国产库果真想的很到位

可视化界面

中文分词可视化

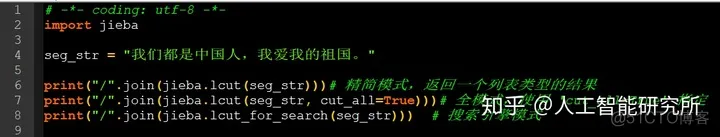

jieba库是一款优秀的 Python 第三方中文分词库,jieba 支持三种分词模式:精确模式、全模式和搜索引擎模式

Window环境下,在cmd命令框中输入: pip install jieba 进行安装即可

jieba分词

LTP(哈工大)提供了一系列中文自然语言处理工具,用户可以使用这些工具对于中文文本进行分词、词性标注、句法分析等等工作。

模型下载

这里需要下载对应的模型版本,否则会出现模型无法运行

python 操作pyltp

LTP提供的模型包括:(在ltp_data文件夹)

cws.model 分句模型,单文件

ner.model 命名实体识别模型,单文件

parser.model 依存句法分析模型,单文件

pos.model 词性标注模型,单文件

pisrl.model模型等等,我们可以根据已经训练好的模型进行中文的分词或者其他操作

以上我们便打造了一个LTP的分词任务,当然,你也可以加载其他模型,进行不同的分词任务,且可以加载大量的文本,只需要segmentor.segment文件里面输入打开的文件便可

当然跟hanlp一样,LTP同样提供了可视化操作界面LTP可视化:可以到官方网站,进行可视化的操作http://ltp.ai/demo.html

LTP可视化